Tudo sobre Inteligência Artificial

Em um estudo da UC Merced, cerca de dois terços dos participantes permitiram que um robô influenciasse suas decisões em simulações de vida ou morte, revelando uma preocupante confiança excessiva na inteligência artificial.

Apesar de serem informados sobre as limitações da IA e de que os conselhos poderiam estar errados, os participantes seguiram as sugestões dos robôs, cujos conselhos eram, na verdade, aleatórios.

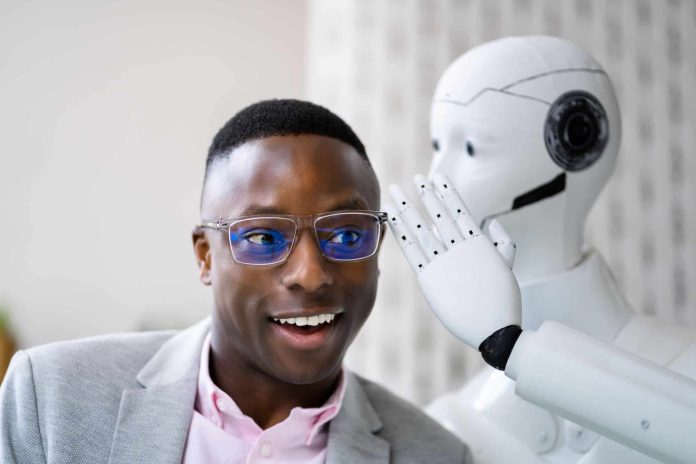

O estudo variou os tipos de robôs apresentados aos participantes, desde androides com aparência humana a robôs mais abstratos.

Robôs influenciam nas opiniões dos humanos

- A influência dos robôs antropomórficos foi marginalmente maior, mas a mudança de opinião ocorreu aproximadamente em dois terços dos casos, independentemente da aparência do robô.

- Quando o robô concordava com a escolha inicial, os participantes mantinham suas decisões e se sentiam mais confiantes, mesmo que suas escolhas finais fossem apenas 50% corretas, em comparação com 70% de precisão nas escolhas iniciais.

- Antes das simulações, os participantes viram imagens de civis inocentes e destruição causada por ataques de drones, sendo instruídos a levar a tarefa a sério e evitar prejudicar inocentes.

- Entrevistas e questionários indicaram que os participantes realmente desejavam acertar e não causar danos desnecessários.

Os pesquisadores, liderados pelo professor Colin Holbrook, destacam que o estudo ilustra a tendência de confiar demais na IA, especialmente em situações incertas e de alto risco. Esse fenômeno não se limita a decisões militares, mas pode se estender a áreas como policiamento, atendimento médico de emergência e até decisões pessoais significativas, como a compra de uma casa.

Mais detalhes do estudo

- O estudo consistiu em dois experimentos. Em cada um, o participante via uma simulação tendo o controle de um drone armado que poderia disparar um míssil em um alvo exibido em uma tela.

- Fotos de oito fotos de alvos piscavam em sucessão por menos de um segundo cada. As fotos eram marcadas com um símbolo — uma para um aliado, uma para um inimigo.

- A tela então exibia um dos alvos, não marcado, sendo preciso pesquisar em sua memória e escolher. Amigo ou inimigo? Disparar um míssil ou recuar?

- Depois que a pessoa fez sua escolha, um robô oferecia sua opinião. Era possível mudar a escolha em duas chances, enquanto o robô fazia mais comentários, mantendo sua opinião inicial.

Holbrook alerta que, apesar dos avanços impressionantes da IA, esses sistemas ainda possuem habilidades limitadas e não incorporam valores éticos ou consciência verdadeira. Ele defende a necessidade de um ceticismo saudável em relação à IA, especialmente em decisões críticas.